- 경량화의 다양한 관점 : 포커스를 어디에 둘까 ?

- 모델크기(=파라미터 수)

- 속도

- 연산횟수 (FLOPs)

- MACs (Multiply-accumulate operations)

- 합, 곱 연산의 횟수

- MACs ~= 0.5 FLOPs

- 속도를 측정하기 어려운 상황에서의 대한

- 속도에 영향을 주는 요소에 대한 insight ( ShuffleNetv2 논문 )

- FLOPs 이외의 Memory Access Cost 관점에서 속도에 영향을 주는 요소를 고려

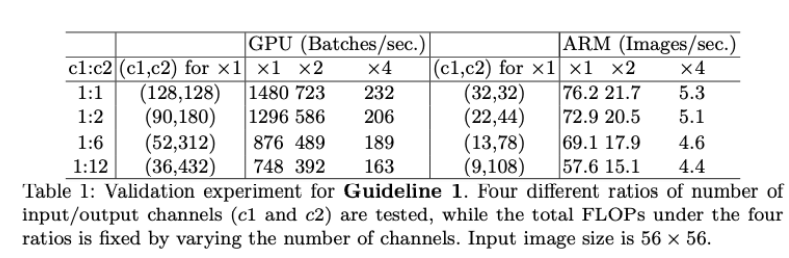

- 입 출력의 채널 크기가 동일 o

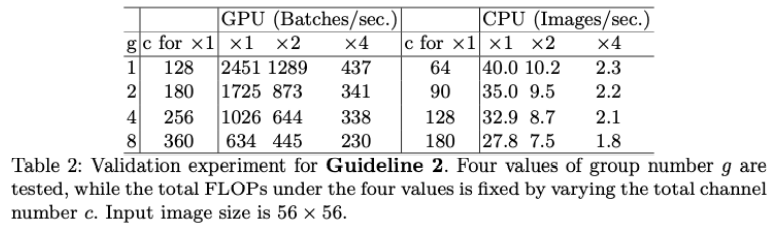

- 큰 Group convolution x

- 여러 분기의 path가 나오는 구조는 병렬화에 악영향

- Element-wise operation은 무시하지 못할 비중을 가짐

https://arxiv.org/abs/1807.11164v1

ShuffleNet V2: Practical Guidelines for Efficient CNN Architecture Design

Currently, the neural network architecture design is mostly guided by the \emph{indirect} metric of computation complexity, i.e., FLOPs. However, the \emph{direct} metric, e.g., speed, also depends on the other factors such as memory access cost and platfo

arxiv.org

'부스트캠프 AI Tech > 모델 최적화' 카테고리의 다른 글

| [03] 좋은 모델과 파라미터 찾기 : AutoML 이론 (0) | 2021.11.29 |

|---|---|

| [01] 모델 경량화 개요 (0) | 2021.11.24 |

| [00] 피어세션 / 학습 회고 / 수행 과정 / 결과물 중간 정리 (0) | 2021.11.24 |