- 모델 구조, 하이퍼 파라미터 <-> train & eval 과정

- -> End-to-end AutoML

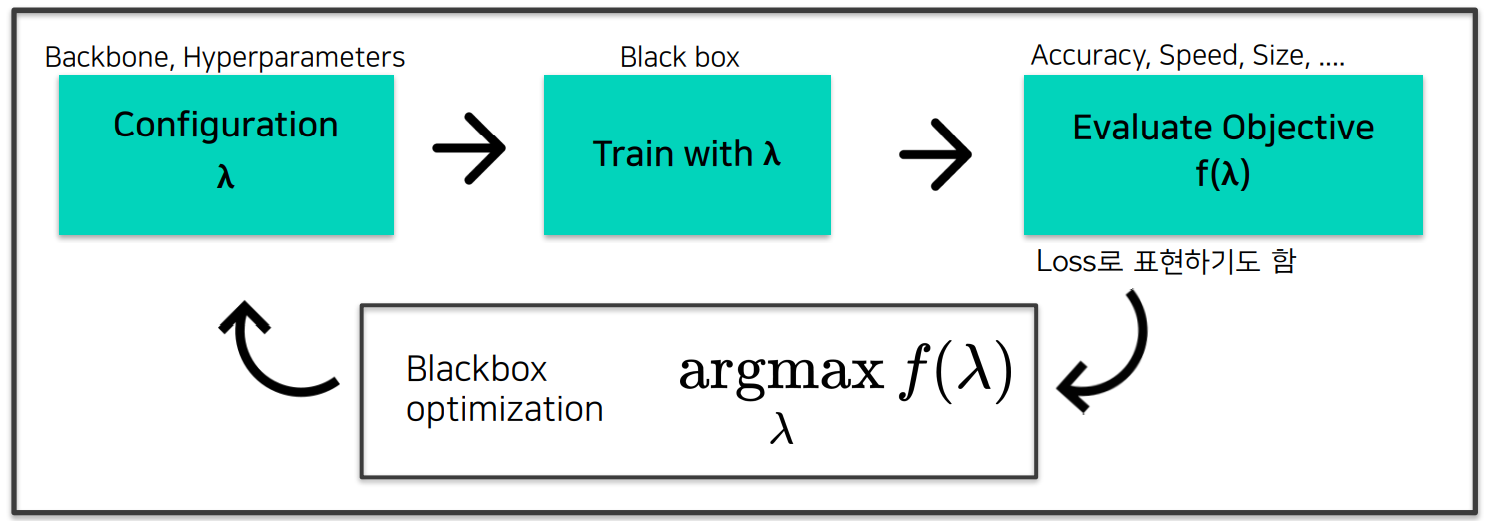

- 일반적인 AutoML pipeline

- Bayesian Optimization

- Hyperparameter Optimization

- manual search

- 직관에 의해서 hyperparameter를 바꿔가며 대입하는 방식이다.

- grid search

- 가능한 hyperparameter 경우의 수를 일정구간으로 나눠서 구간별로 균일하게 대입해보는 방식이다.

- random search

- 가능한 hyperparameter 조합을 random하게 선택해서 대입해보는 방식이다.

- manual search

더보기

보통 grid search나 random search가 주로 쓰이는데, 이 둘의 문제는 다음 hyperparameter 후보를 찾는 과정에서

이제까지의 사전지식(실험결과)가 반영되지 않는다는 것이다. -> BO (Bayesain Optimization)

- Bayesian Optimization

- 현재까지 조사된 데이터를 토대로 목적함수를 추정하는 모델을 Surrogate Model

- 추정된 모델을 토대로 다음에 넣으면 좋을법한 입력 데이터를 추천하는 함수를 Acquisition Function

- Surrogate Model

- 가장 많이 사용되는 확률 모델은 Gaussian Process Regression(GP)

- https://distill.pub/2019/visual-exploration-gaussian-processes/

- GP는 직관적으로 이해하면 일종의 함수고 각 입력에 대해서 normal distribution random variable을 출력하는 함수라고 생각하면 된다.

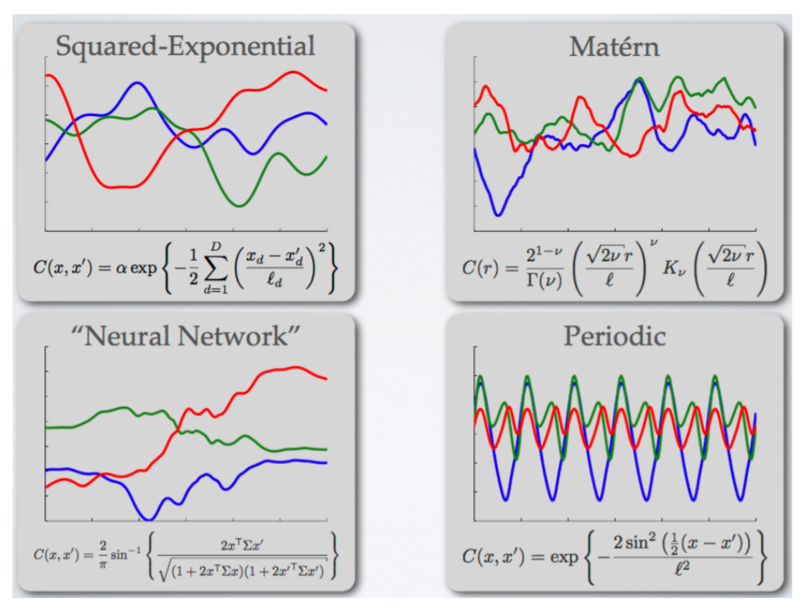

- Gaussian Process는 mean function과, covariance function으로 정의가 되는데, 논문에 따르면 mean function은 별로 중요하지 않고 covariance function이 중요하다고 한다.

- 이 두가지가 정해지고 나면, 임의의 모든 점에 대한 확률분포를 얻어낼 수 있다.

- 여기서 covariance function은 kernel function을 통해 얻어내게 되는데, kernel function은 주어진 GP sample 들이 어떤 relationship을 가지는지 정의하는 함수이다.

- 한 논문(J Snoek et al. 2012)에 따르면 matern 5/2 를 사용했을 때 가장 좋다고 한다

'부스트캠프 AI Tech > 모델 최적화' 카테고리의 다른 글

| [02] 대회 및 데이터셋 소개 (0) | 2021.11.29 |

|---|---|

| [01] 모델 경량화 개요 (0) | 2021.11.24 |

| [00] 피어세션 / 학습 회고 / 수행 과정 / 결과물 중간 정리 (0) | 2021.11.24 |